近期,百度智能云发布了一份深度报告,聚焦于2024年大模型时代的异构计算平台发展。该报告详尽地探讨了随着GPT-3等大模型的崛起,训练过程中的技术瓶颈与应对之道。

GPT-3等大模型的诞生标志着大模型时代的到来,它们在效果和通用性上的显著提升引起了业界的广泛关注。然而,这种进步也带来了前所未有的训练需求。以GPT-3为例,其1750亿参数和3000亿词语的庞大体量,使得计算量高达314 ZFLOPs。如果使用单张A100显卡,需要32年才能完成训练。千亿参数所需的2TB存储空间,也远超单卡80GB的显存限制。这些挑战迫使业界寻求分布式加速和更多存储空间的解决方案。

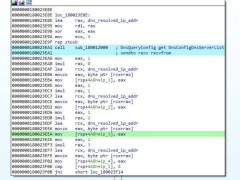

面对算力墙和存储墙的困境,报告提出了多种模型切分技术。数据并行通过梯度同步确保多卡参数的一致性,常用的同步策略包括同步更新和异步更新,当前主流做法是同步更新。流水线并行则让每张显卡保存模型的部分层,并同步激活与梯度。张量并行则将单层操作分割到多张显卡上。分组参数切片则是对数据并行中的显存冗余进行优化,以节省显存。

在硬件资源和网络设计上,报告指出,单机硬件的选型需要注重高算力和机内多卡通信能力,如配置8张NVIDIA A100显卡等。集群网络则采用8导轨优化的三层CLOS架构,可以支撑万卡级别的规模,并重点优化同号卡的AllReduce操作。

在软硬件结合的优化方面,报告介绍了基于静态图的多后端加速架构,该架构包括图接入、后端抽象、图优化和图转换等环节。图接入融合了动态图和静态图的优势,通过多种方式实现。后端加速则涉及计算执行时间分析、算子融合和算子实现优化。通信优化针对交换机哈希冲突、All2All加速和使能Infiniband等问题,提出了具体的解决方案。端到端自动化任务切分与放置通过构建cost model,搜索最优方案。

报告中还提及了在大模型训练中减少计算量的方法,如条件计算和混合专家模式。这些方法根据条件激活部分参数,将模型拆分为子网络,从而降低了计算量。

随着大模型的发展,参数规模持续增加,多模态训练逐渐兴起,算力需求也大幅增长。这些趋势将推动基础设施的不断演进。百度百舸·AI异构计算平台2.0应运而生,为城市大脑、工业互联网等业务场景提供了有力支持,满足了大模型训练和应用的多样化需求。