蚂蚁集团近日宣布开源全球首个基于混合线性架构的万亿参数思考模型——Ring-2.5-1T。该模型在生成效率、推理深度和长时程任务执行能力三大核心指标上实现突破,尤其在数学竞赛、长文本生成和智能体任务处理领域达到开源模型领先水平,标志着大模型技术向复杂场景应用迈出关键一步。

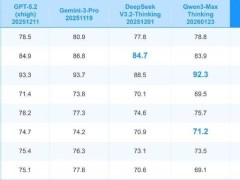

在数学推理能力验证中,Ring-2.5-1T展现出卓越表现。该模型在国际数学奥林匹克竞赛(IMO 2025)自测中取得35分(满分42分),中国数学奥林匹克(CMO 2025)自测更以105分(满分126分)远超金牌分数线。研究人员通过对比发现,新模型在推理逻辑严谨性、高级数学证明技术应用及答案完整性方面较前代Ring-1T有显著提升。在编程与逻辑推理基准测试中,该模型在LiveCodeBench-v6代码生成、HMMT-25数学竞赛等任务中均超越DeepSeek-v3.2-Thinking、Kimi-K2.5-Thinking等开源模型及GPT-5.2-thinking-high等闭源系统。

针对长时程任务处理,Ring-2.5-1T通过大规模异步智能体强化学习训练,在Gaia2-search智能体搜索任务中取得开源模型最优性能。该任务要求模型协调跨应用工具完成复杂操作,新模型在规划生成与多步工具调用效率上较前代提升40%。在软件工程基准测试中,其于SWE-Bench Verified任务中的表现超越Claude-Opus-4.5-Extended-Thinking等主流模型,展现出解决实际工程问题的潜力。

技术架构层面,Ring-2.5-1T基于创新的Ling 2.5混合线性注意力机制,将内存访问开销降低至前代的1/10。通过将分组查询注意力(GQA)升级为1:7比例的多头线性注意力(MLA)与Lightning Linear结构组合,模型在32K以上长文本生成场景中吞吐量提升3倍。实验数据显示,在配备8块H200 GPU的服务器上,当生成长度超过16K token时,其解码效率较Kimi K2架构提升65%,且优势随文本长度增加持续扩大。

该模型激活参数规模从51B扩展至63B,但通过优化KV缓存压缩技术,在保持推理效率的同时降低了计算资源消耗。研究人员特别改进了查询-核归一化(QK Norm)与部分旋转位置编码(Partial RoPE)机制,使模型在处理超长序列时仍能维持稳定性能。目前,Ring-2.5-1T的模型权重与推理代码已在Hugging Face、ModelScope等平台开放下载,官方API服务与交互体验页面将于近期上线。

在应用适配方面,新模型已实现与Claude Code智能体编程框架及OpenClaw个人AI助手的无缝对接,支持多步规划与工具链调用。技术团队透露,通过底层架构创新,Ring-2.5-1T有效解决了传统模型在长文档处理、跨文件代码理解等场景中面临的算力成本高、响应延迟大等难题,为金融、法律、科研等需要深度推理的行业提供了高性能技术方案。